智能计算需求飙升,液体冷却迎爆发前夜

21世纪经济报道记者骆轶琪郑州报道

从2022年末ChatGPT发布至今,AI大模型的模型参数及技术架构持续演进,由此对智能算力的需求也在飙升,相关基础设施产业链都在面临新的变化。

近日举行的“2024智算时代数据中心技术引领与变革论坛”上,中国信通院云大所数据中心部总工程师郭亮在演讲中指出,算力中心发展经历了三个阶段:在2000-2010年间,数据中心由三大通信运营商为主导;2010-2020年间,随着数据中心需要更多专业技术能力加持,开始有第三方数据中心服务商加入;到现在的智算中心时代,数据中心主体开始呈现百花齐放的发展态势,但同时也面临寻找正确的发展路径命题。

这不同于此前以CPU为主导的发展时代,在GPU为主导时代,包括底层芯片、基础设施、网络架构、应用生态等方面发生了较大变化,产业链厂商亟需密切联合,探路新技术路线下的演进方向。

秦淮数据CTO张炳华对21世纪经济报道记者表示,目前国内第三方数据中心服务商主要有两种运营模式:超大规模定制模式和传统通用零售模式。随着AI大模型快速发展,对数据中心的需求走向更大规模AI集群,超大规模定制模式的优势凸显。对此,秦淮数据升级发布“智算中心全栈解决方案2.0”,并联合生态伙伴,共同启动相关行业标准立项。

业内认为,伴随国内智能计算生态的能力演进,并在此过程中推动产业走向标准化,将有望更好抢占AI浪潮下的新发展机遇。

需求激增

中国信息通信研究院发布的《算力中心冷板式液冷发展研究报告(2024年)》(下称“报告”)显示,截至2023年底,我国在用算力服务机架数已达到810万标准机架,算力总规模达230EFLOPS。大型以上算力中心机架数量占算力中心总机架规模比重逐年上涨,部分超大型算力中心的平均单机柜功率已达20kW。由此可见,高功率密度、高算力的大型、超大型算力中心将是未来建设的重点。

这也意味着面对GPU为核心的智算中心基础设施生态需要快速应变。

郭亮指出,目前智算中心的生态发展以英伟达CUDA生态一枝独秀,在早期以CPU为核心的X86时代,虽然主导厂商数量也少,但芯片和应用、基础设施之间没有过强的耦合关系;到了AI时代,从底层芯片到网络、框架、应用、基础设施,彼此之间耦合度极高,由此导致一家厂商占据了80%~90%的极高份额。因此,行业企业如何找到自己的定位、围绕算力基础设施做更多开创性工作成为重要话题。

从基础设施、网络、计算、运营多个方面带来机会同时也有挑战:如何将网络与计算融合是当前被高度关注的话题;基础设施主要包括电和冷,近期微软、甲骨文相继宣布要重启关闭多年的核电站,就是基于电力紧俏而做出应对,冷即散热方式从风冷转向液冷;运营主要指目前政策层面推进的算力调度平台建设。

技术和生态面临较多转向、需要产业链协同解决问题比较多,其中一个重点就包括散热方式。

张炳华分析,在通用计算发展时期,CPU芯片功耗从2010年到2019近十年仅增长了一倍左右,单机柜功率从几千瓦提升到十千瓦;但在智能计算发展时期,GPU卡的功耗持续翻倍,GPU服务器单机柜功率密度从原来的近十千瓦左右,提升到现在的一百三十多千瓦,提升了十几倍。这让功率密度、消耗电量等方面大幅提高,由此带来新的散热命题。

“在我们看来,数据中心在同样条件下,如何保证芯片、服务器和网络安全稳定运行,根本问题是解决供电、制冷、遭遇故障后冗余等方面问题。”他续称,这就需要从基础设施系统架构、设计方案,到产品化、预制化等方向推进,由此进行标准化落地,也更容易实现规模效益。

前述会议上,秦淮数据推出“磐石”模块数据中心框架,包括高弹性建筑模型、“玄铁”极简供电架构、“玄冰”极致冷却架构和“玄智”智能运维系统,以支持高密及超高密智算场景。

其中,高弹性建筑模型的模块架构可灵活配置、分期预制,同时兼容CPU和GPU不同算力场景;“玄铁”架构将传统配电全链路的10余个环节设备融合成变电站、柴发、中压、低压、电池、IT六大机电模块,可分阶段部署和弹性扩容;“玄冰”架构包括风冷、液冷、风液兼容等模块,以解决8kW-150kW区间所有功率密度的机柜冷却难题。

张炳华对21世纪经济报道记者表示,采取通用方案来建设机房的基础设施,从建筑封顶到正式投入运营期间会有3-6个月的准备期,用来安装供电、冷却等系统。目前采用液冷方案需要更长的建设周期、更长的服务器研发周期,为了尽快上线大模型,获得比竞对更高的算力,客户会优先选择能够更快部署的风冷方案。所以在风冷向液冷方案转换的初期,鉴于风冷散热方案成熟且通用,以及企业对采用新技术路线可能带来的风险存在担忧,大部分客户缺乏积极主动选择液冷方案的动力。

“目前颇受关注的冷板液冷方案也面临如水质、冷却液泄露、微通道拥堵甚至腐蚀等问题,一旦设计方案不合理、建设质量没有保证、运维管理不当等,对业务运行来说会面临更高的故障风险。但风冷散热能力已达极限,无法适应未来高密度机柜的冷却需求,因此,当下阶段液冷小规模的尝试和验证一定要做,这是未来通向大规模使用场景的必经阶段。”他续称。

需求驱动下,当前液冷技术已经在快速渗透。调研机构IDC统计显示,中国液冷服务器市场在2024上半年继续保持快速增长,市场规模达12.6亿美元,同比增长98.3%,其中液冷解决方案仍以冷板式为主,占95%以上。根据调研机构IDC的统计和预测,2023-2028年,中国液冷服务器市场年复合增长率将达到47.6%,2028年市场规模将达到102亿美元。

液冷加速

张炳华对21世纪经济报道记者分析,从传统风冷向液冷转换过程中,面临的本质上并不是单一商业逻辑难题,更多源于当前液冷散热生态不够成熟。

例如服务器在液体中运行时,遇到一些液体会产生化学反应,这在过去行业并没有积累足够的应对经验,需要较长时间来对主要液体材料的兼容性和稳定性进行验证。但考虑到GPU成本偏高,且并不对浸没式液冷方案承诺质保,令厂商尝试浸没式液冷时有更多顾虑。

这与新技术在发展早期面临的标准化、兼容性不足有关。但产业界已经在驱动解决这一现状。

前述《报告》分析,当前我国针对液冷技术的研究仍处于起步阶段,液冷服务器的设计、运维、安防等方面的行业标准较为空缺,业内尚未形成统一的技术标准,增高了产业发展壁垒。得益于政策支持与引导,液冷产业标准规范化迎来了快速发展。特别是冷板式液冷技术标准制定逐步朝向常态化、规范化迈进。

目前市场上的液冷方案主要包括三类:冷板式液冷、浸没式液冷、喷淋式液冷。张炳华认为,在多个液冷散热方案中,冷板液冷相对更成熟、对现有服务器生态的改变更少,因此业界目前更侧重于推进冷板液冷方案完善。

“如果要采用浸没式液冷方案,对服务器网络、电源等生态都要有较大改变。在液冷方案发展初期会不太具备规模效益。但冷板液冷方案可以同时适配GPU、CPU等主计算单元的能力和生态。相比之下,从风冷方案改为冷板液冷方案的难度更小。”他进一步指出。

IDC中国服务器市场研究经理辛一认为,从全球范围看,液冷方案目前在海外的应用尚不广泛,只在一些头部CSP(云服务商)的集群节点中有所应用。英伟达最新的Blackwell平台预计在今年末或2025年初在全球范围大量出货,新平台自身功耗较高,自然对液冷方案的应用起到促进作用。

“如果中国在此时机下,不论是服务器产品设计、制造、销售和维护方面,还是液冷数据中心基础设施建设等领域积累丰富经验,必将在整个液冷市场中发挥重要作用。同时,还需要产业相关组织、机构、企业及合作伙伴,在液冷方案实际应用过程中精诚合作,共同制定适合液冷发展的行业或组织标准,加快促进产学研的高效融合。”他续称。

前述论坛上,“冷板液冷系统全生命周期质量控制规范系列行业标准”启动立项,专家组同期成立。该系列标准将由中国信通院和秦淮数据牵头,联合数十家行业头部企业共同编制。

张炳华告诉记者,目前国际上对于液冷散热技术虽然没有形成完整统一的标准,但并不意味着对液冷方案没有技术要求。在这些要求逐渐完善后,才会形成标准定式。

此前对数据中心制定标准主要由互联网厂商牵头,但在智能计算发展需求下,服务器硬盘布局进行了重新设计,改变了既有生态模式。因此,现在需要产业链厂商共同参与完善标准制定,根据各自在产业链中的位置协同开发,对市场发展也更具有引导作用。

“我们在制定标准指导规范时,既借鉴行业的基本原则,也参考了ODCC(开放数据中心委员会)的技术要求等方面考虑。”他续称,秦淮数据希望通过参与ODCC、拉通更多产业链生态等方式,让更多元的行业用户共同参与完善早期标准定义过程。

集邦咨询认为,随着全球政府及监管机构对于ESG(环境、社会和公司治理)意识逐渐提升下,将加速带动散热方案由气冷转液冷形式发展,预期液冷方案渗透率逐年攀升,这将促使电源供应厂商、散热业者及系统整合厂等竞相投入AI液冷市场,形成新的产业竞争与合作态势。

热点推送

-

泰恩康1类创新药CKBA软膏Ⅱ期临床完成全部受试者入组

10月31日,泰恩康发布公告,宣布其控股子公司江苏博创园生物医药科技有限公司(以下简称“博创园”)研发的1类创新药CKBA软膏Ⅱ期临床完成全部受试者入组

2024-11-01泰恩康,CKBA,白癜风 -

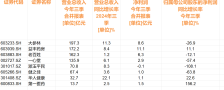

开源证券给予赛轮轮胎买入评级 公司信息更新报告:Q3业绩符合预期 全球化布局稳步推进

开源证券10月31日发布研报称,给予赛轮轮胎(601058.SH,最新价:14.51元)买入评级。评级理由主要包括:1)Q3公司产销量延续上行,中期分红兼顾未来发展和股东回报;2)拟投资建设“柬埔寨贡布经济特区项目”,全球化布局稳步推进

2024-11-01赛轮轮胎,开源证券,买入评级 -

中国市场业绩低个位数下滑!联合利华:预计未来定价会上涨

10月24日,消费品巨头联合利华发布2024年三季报。2024年前三季度,联合利华销售额同比增长1.3%至464亿欧元,基础销售额(USG)同比增长4.3%。前三季度,联合利华基础销量(UVG)提升2.9%,基础价格(UPG)提升1.3%

2024-11-01联合利华,中国,业务 -

民生证券给予三棵树推荐评级 2024年三季报点评:产品价格继续承压 现金流质量有所改善

民生证券10月31日发布研报称,给予三棵树(603737.SH,最新价:44.6元)推荐评级

2024-11-01三棵树,民生证券,现金流 -

公司热点|葫芦娃三季度净利大跌68% 第三大股东抛减持计划

葫芦娃(605199)10月31日晚间公告,因自身资金需求,股东中嘉瑞拟自公告之日起15个交易日后的3个月内,通过大宗交易减持股份不超过534.11万股,不超过公司总股本的1.34%。具体减持价值将按市场价格确定

2024-11-01葫芦娃,公司,减持 -

星巴克启动“重返星巴克”计划

新上任的星巴克CEO布莱恩·尼科尔10月30日再提“重返星巴克”计划,全面改革星巴克美国门店,包括增加更舒适座位、陶瓷杯等,并将顾客等待时间缩短至四分钟以下。尼科尔称,为帮助实现上述目标,并使价格清晰明了,星巴克还将简化菜单

2024-11-01星巴克,市场,中国 -

华安证券给予青鸟消防买入评级 青鸟消防:工业及海外市场持续发力 高度重视研发

华安证券10月31日发布研报称,给予青鸟消防(002960.SZ,最新价:10.51元)买入评级

2024-11-01青鸟消防,华安证券,风险 -

华安证券给予国机通用增持评级 国机通用:聚焦核心业务 盈利能力持续改善

华安证券10月31日发布研报称,给予国机通用(600444.SH,最新价:16.37元)增持评级

2024-11-01国机通用,华安证券,增持评级 -

伊利股份: 全品类业务动销持续向好 加码新战略布局

“四季度,液奶能够更好地轻装上阵,并且在奶粉等业务持续向好的带动下,预计四季度公司的整体收入会继续呈现环比改善的趋势。在盈利方面,我们希望全年在扣除一次性损益后,主业利润率能够有所提升。”乳业龙头伊利股份在三季报业绩说明会上释放出积极信号

2024-11-01伊利,乳制品,三季度 -

比亚迪季度营收首破2000亿元 今年1-9月销量274.8万辆 同比增长32%

10月30日晚,比亚迪发布2024年三季报。报告显示,比亚迪第三季度公司实现营收2011.25亿元,同比增长24.04%,单季度营收首次突破2000亿元;实现归母净利润116.07亿元,同比增长11.47%,营收、净利润都实现了新突破

2024-11-01比亚迪,轿车,销量 -

乐信CEO肖文杰:走在创新前沿 选择深圳创业

“作为从深圳起家和发展壮大的中国领先新消费数字科技服务商,乐信一直致力于以科技之力让消费更美好。”乐信CEO肖文杰在接受记者采访时说道。 2013年,肖文杰创办了中国首家分期电商平台分期乐,开创了中国分期购物电商新模式

2024-11-01乐信,二季度,公司 -

欧洲三大股指收盘全线下跌 德国DAX指数跌1.02%

欧洲三大股指收盘全线下跌,德国DAX指数跌1.02%报19060.34点,法国CAC40指数跌1.22%报7337.64点,英国富时100指数跌0.61%报8110.1点

2024-11-01德国DAX指数,1.02,欧洲 -

谷歌母公司Alphabet旗下自动驾驶部门Waymo在新一轮融资过后估值超过450亿美元

谷歌母公司Alphabet旗下自动驾驶部门Waymo在新一轮融资过后估值超过450亿美元

2024-11-01Alphabet,谷歌,自动驾驶 -

宝安境内外上市企业达78家 强达电路在创业板挂牌 成为今年宝安第3家新增A股上市企业

10月31日,深圳市强达电路股份有限公司(简称“强达电路”)在深交所创业板正式挂牌上市,成为今年宝安第3家、深圳第6家新增A股上市企业

2024-11-01强达电路,PCB,创业板 -

迅雷集团董事长兼CEO李金波:聚焦全球化 增强营收力

在深圳这座创新之城、科技之城、梦想之城,无数企业如雨后春笋般涌现。其中,迅雷集团从下载领域的引领者,如今已成长为中国领先的提供分布式云服务的技术公司,正打造全球最大去中心化传输与存储网络

2024-11-01李金波,迅雷,企业 -

正大首次收购A股公司 浩欧博复牌一字涨停

10月30日晚,浩欧博发布公告称,正大集团旗下的港股中国生物制药拟采用“协议转让+部分要约”的方式收购公司55%股份,获得公司控制权。这也是“并购六条”发布后首单科创板公司被收购,同时也是正大集团首次收购A股公司

2024-11-01浩欧博,中国生物制药,公司 -

OpenAI在ChatGPT增添搜索功能 挑战谷歌

OpenAI正在为其旗舰产品ChatGPT增加一套新的搜索功能,使这家人工智能初创公司对Alphabet旗下谷歌的挑战进一步升级

2024-11-01ChatGPT,谷歌,OpenAI -

在城博会窥见建筑新质生产力

来到第十年,上海国际城市与建筑博览会依然有料。一座城市里,最前沿的建筑产品、技术和服务,被搬进了在占地4.2万平方米的展区里,现场处处可以窥见新质生产力。 10月31日,城博会作为今年世界城市日在沪重要活动之一正式启幕

2024-11-01水泥,国和一号,上海 -

药店连锁净利增长进入“慢车道” Q4起或迈向新平衡

中大型药店连锁门店数量仍在扩张中,但收购已趋于谨慎,由于行业竞争激烈,新店培育期拉长,增收难增利成为行业普遍面临的难题

2024-11-01连锁,行业,药店 -

大消息!这个平台 刚上线

10月31日,金融产品一站式查询平台正式上线,覆盖银行理财、保险、信托、保险资管四类金融产品。 金融产品官方查询平台上线 金融消费者购买的金融产品,有了统一的官方查询平台

2024-11-01查询,金融产品,金融 -

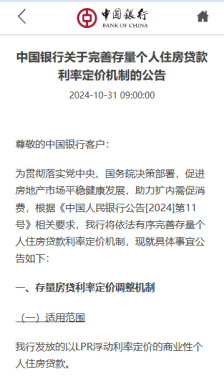

六大国有银行公告 11月1日起陆续对商业性个人住房贷款利率实行新的定价机制

存量房贷利率定价机制新变化,11月1日起开始实行。 10月31日,工商银行、农业银行、中国银行、建设银行、交通银行、邮储银行六大商业银行发布公告,将从11月1日(明天)起,陆续对商业性个人住房贷款利率实行新的定价机制

2024-11-01房贷利率,定价,银行 -

深夜突发 跌到熔断!全球资产 全线跳水!发生了什么?

多种因素作用下,今晚,全球资产集体飘绿。 全球资产下跌 晚间,美国三大指数集体低开。 特朗普媒体科技集团直接触发熔断,熔断前跌13.84%,目前已恢复交易。 欧洲方面,英法德几大重要指数集体下跌

2024-11-01微软,美元,人工智能 -

青海降低存量房贷利率 统一首套、二套房贷最低首付比例为15%

中新网西宁10月31日电(李隽)31日,记者从中国人民银行青海省分行获悉,该行以下调存款准备金率和政策利率,统一首套、二套房贷最低首付比例,降低存量房贷利率等多举措落实支持性货币政策,为经济稳定增长和高质量发展创造良好货币金融环境

2024-11-01房贷利率,定价,银行 -

深夜突发 全球资产集体下跌 特朗普媒体科技集团一度跌到熔断!

北京时间10月31日晚,全球资产集体下跌。 美股低开低走。截至发稿,道琼斯指数跌0.81%,纳斯达克指数跌2.25%,标普500指数跌1.43%。 纳斯达克中国金龙指数目前跌1.81%,理想汽车、小牛电动、世纪互联等跌幅居前

2024-11-01微软,特朗普媒体科技集团,雅诗兰黛 -

俄罗斯对谷歌开出35位数罚单 网友:不会读了……

10月31日,#谷歌被俄罗斯罚款35位数#话题冲上微博热搜第一。 据外媒10月30日报道,俄罗斯政府对谷歌的罚款已达约20000000000000000000000000000000000(35位数字)美元

2024-11-01谷歌,俄罗斯,罚款 -

公众环境研究中心主任马军:应对全球气候变化 中国做出最务实且大的努力

10月31日,由公众环境研究中心、海因里希·伯尔基金会(德国)北京代表处主办的“2024绿色供应链暨气候行动论坛”在北京举办。 公众环境研究中心主任马军在CITI和CATI报告发布演讲中表示,气候变化形势严峻,全球气温和海温持续升高

2024-11-01马军,海洋,气候 -

上港集团:打造智慧绿色枢纽港

东海之滨,舟车辏集,吊机不停。码头上,桥吊矗立岸边,轨道吊灵活运转,自动导引车穿梭其间,一派繁忙景象。 这里是上港集团的洋山深水港区四期自动化码头(简称“洋山四期”)

2024-11-01上港集团,港口,集装箱码头 -

ChatGPT搜索功能强势来袭 谷歌能否保住搜索霸权?

当地时间周四(10月31日),OpenAI在官网宣布,其在ChatGPT中推出了搜索功能,“可以通过相关网络资源的链接获得快速、及时的答案

2024-11-01搜索,ChatGPT,谷歌 -

郭明錤:超微电脑停牌或退市可能性正在增加

知名分析师郭明錤撰文称,根据经验,审计机构辞任是一个严重的信号,超微电脑(SMIC.O)面临停牌或退市等最坏情况的可能性正在增加。这将间接削弱超微的竞争力,给其生存带来巨大挑战,尤其是其竞争对手都是资金雄厚、资源丰富的大厂商

2024-11-01超微电脑,美股,审计机构 -

天玛智控:煤矿智能化建设开拓者

沉浸式采煤越来越多地应用于煤炭开采过程。为我国煤炭行业带来首套无人化采煤工业常态化应用解决方案的企业,就是中国煤科所属科创板上市公司天玛智控

2024-11-01天玛智控,采煤,煤矿